在内容营销的过程中,数据的作用毋庸置疑。记得我刚开始工作的时候,要批量去抓取网站的数据,基本都需要通过写代码的方式。想省时省力得抓到自己想要的数据,并不是一件容易事。

后面慢慢出现了像火车头、八爪鱼这样的 No Code 工具,才使得数据的抓取变得容易了一些。但要想抓到非常自定义的数据,也并不是那么方便(还是得写代码)。

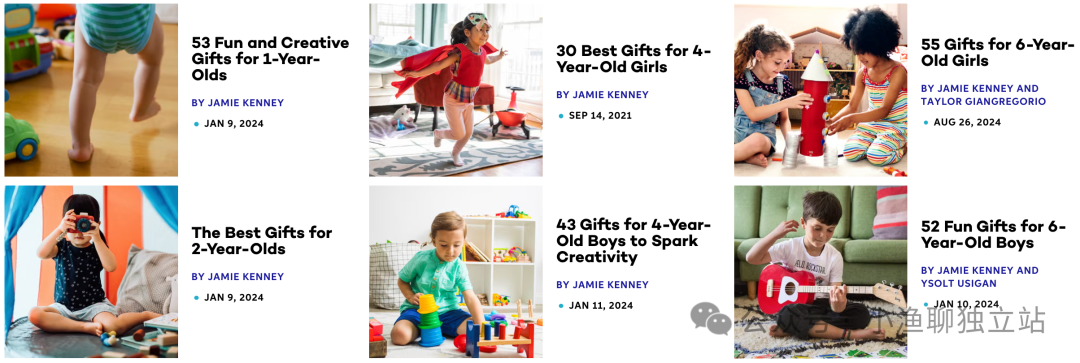

由于最近我一直在做 Programmatic SEO,需要采集不同网站上的不同数据,所以就花了点心思在调研各种数据抓取方案的比较上。

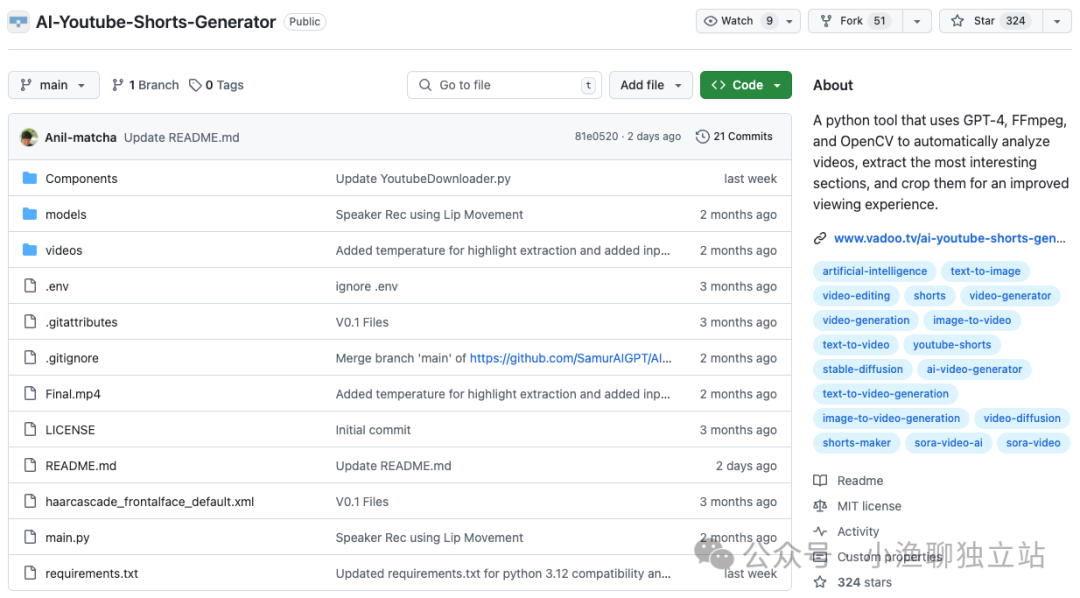

偶然间发现了一种最近比较流行的开源爬虫(FireCrawl),自认为还是挺有研究价值的,专门用一篇文章记录下。

偶然间发现了一种最近比较流行的开源爬虫(FireCrawl),自认为还是挺有研究价值的,专门用一篇文章记录下。

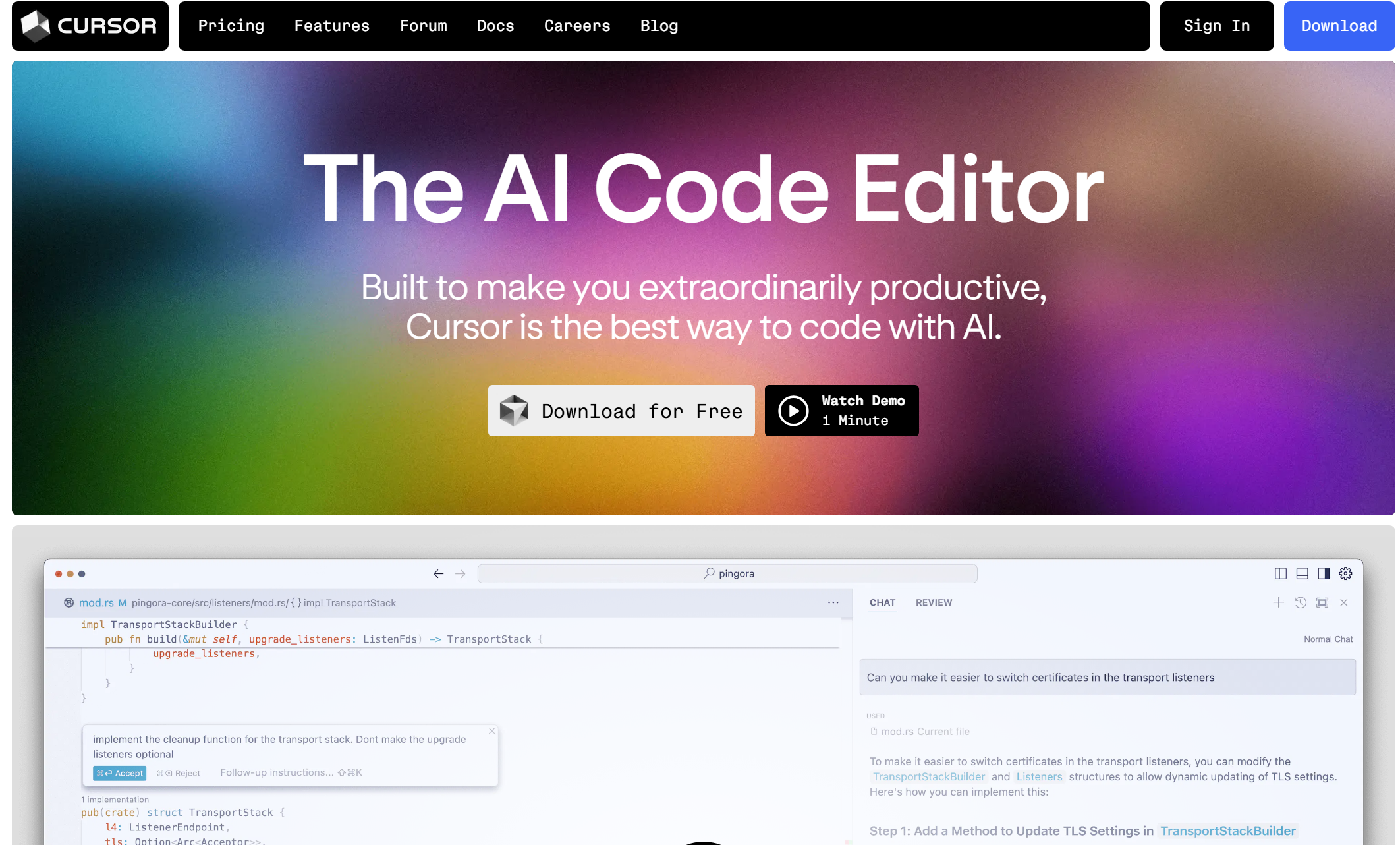

首先,使用这款工具可以很轻松将网页的信息整理下来,即将 URL 链接上的信息转化为 Markdown 格式的数据。并且这些数据可以很轻松的投喂给大模型,以便对数据后续的进一步加工。

比如我现在想抓取我博客的内容,只需要简单将链接扔到输入框里点击确定,稍等片刻便可以看到所有的数据都已经使用 Markdown 格式整理好了。

并且,这款爬虫还支持各种各样的 SDK,支持自定义部署。同时也提供 LLM 大模型的接入,也就是直接利用大模型的分析能力,将网页上的数据格式化整理后呈现出来,且整个过程根本不需要我们写什么代码。

至于具体的自定义部署,我现在还没来得及研究。但我脑子里能清楚知道,这玩意儿结合 Programmatic SEO,真的有挺多有意思的玩法。这里先卖个关子吧,等我哪天做成了再来分享。

所以现阶段的主要任务就是熟悉这套程序,搞明白如何高效率使用。可能得话再将这套流程纳入到自己的工作流中去,进一步提升工作效率。

大家有兴趣的可以去试试。

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。