前几天我的文章中有写网站收录不断掉的问题,尤其是小语种的信息收录不断的掉,所以这周就打算花点时间来测试下小语种翻译的精准度这件事情。这篇文章就简单说下我的思路,以及数据验证的一些方法。

之前我的那个小语种网站,是在英语版本上进行翻译的。且使用的是插件方案,也就是做好英语版本后,使用小语种插件的自带翻译功能,将英语版本翻译成各自的小语种版本。

然后我周末花了点时间仔细研究了那个插件的翻译机制,发现这款插件使用的是谷歌翻译的 API,将网页内容翻译完成后再填充到页面的。

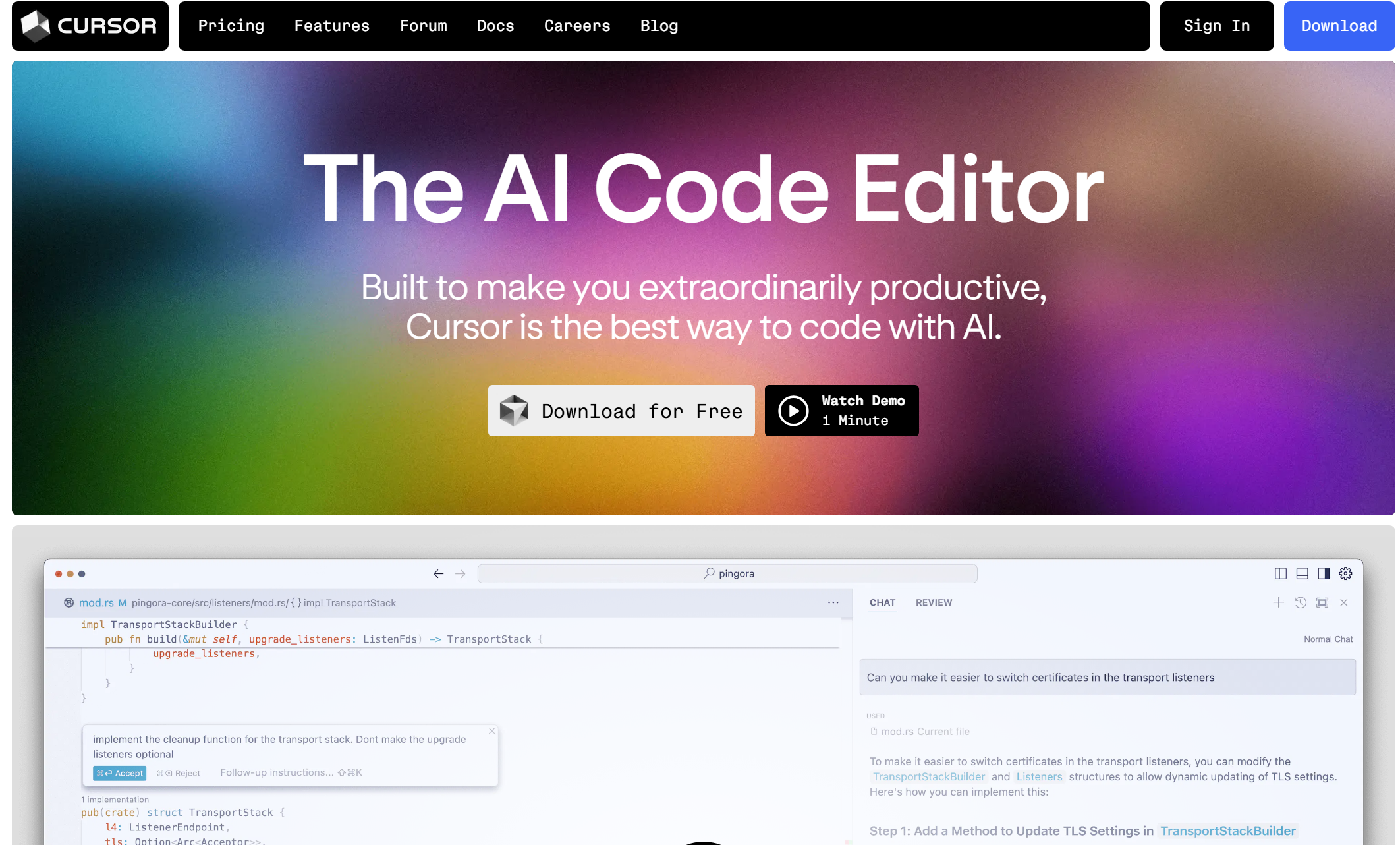

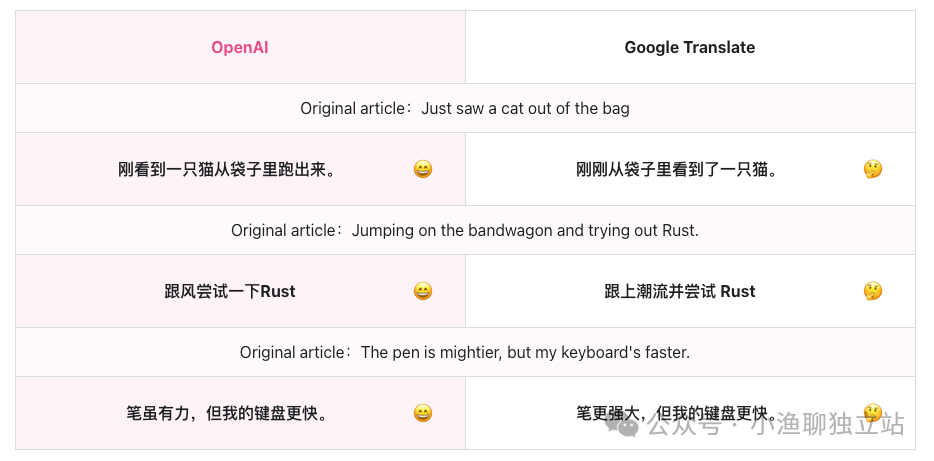

这就有点不妙了,毕竟谷歌翻译的内容质量还是有待商榷的。比如上图这个案例,谷歌翻译在很多语句的细节上做不到「信雅达」,它只是生硬的将英文翻译成中文而已。

所以昨天就干脆将全部的小语种全部删了,不破不立嘛。然后打算自己通过身份设定来训练下 Prompt,从而再将其运用到自己的小语种网站上面。

但问题也就出来了,我现在好像还没有找到一款合适的能集成 OpenAI 的小语种插件。也就是说,后续的小语种的翻译工作,我都需要自己手动去完成。

但问题也就出来了,我现在好像还没有找到一款合适的能集成 OpenAI 的小语种插件。也就是说,后续的小语种的翻译工作,我都需要自己手动去完成。

当然,看到这里肯定会有朋友说,要不要试试 DeepL,这个比谷歌翻译强很多的翻译软件。

其实这个方案我昨天晚上就已经试过了,总体来讲翻译的效果要比谷歌翻译好太多了,但是有个问题不得不承认,就是真的太贵了。

我昨天晚上申请了 Pro 版本 API,并将其整合到自己的网站上。试用没问题后,大约翻译了 40 多个页面吧(翻译成法语),就消耗了 60 多万次字符了,计费账单就显示需要支付 17 美金。

当时看到那个账单真的有点不敢相信,毕竟我的网站现在有 150 多个页面,就法语这个单一站点而言,全部翻译完可能就需要 60 美金左右。试想我要是做 10 个小语种版本呢,成本不得 600 美金?

所以后续我还是想以 OpenAI API 为主,通过将网页上的内容整理好,并利用训练好的 Prompt,得到自己想要的小语种数据。等数据勘验无误后,再手动整理到小语种版本上去。

当然,这套方法我现在还没玩熟,所以先手动操作来熟悉下整个流程,看看过程中会犯哪些错误,并踩踩其中的一些坑。等后续操作熟练后,再来看看能不能有什么自动化的方案。

现在初步的设想是,利用爬虫将网站源数据抓取下来,并分门别类整理到表格中。等这个过程完成后,再去使用 OpenAI API 的数据处理能力,将文本翻译成对应的小语种文案。

至于小语种文案的更新,我可能会考虑使用 RPA 的方案去做。毕竟都是些规律性的操作,完全可以使用程序去自动化掉,节省自己的时间与精力。

后续看看这种方案做出来的小语种网站的数据情况到底如何,两相对比一下(上一版本的小语种数据已经整理好了),就能知道个大概了。