今天又要小伙伴给我微信,说使用不同工具查询出来的关键词搜索量不一致怎么处理。索性还是干脆写篇文章,谈谈不同平台的数据统计差异的问题。

直接看一个案例吧,我拿自己最新的一个站点外链数据来举例(关键词搜索量数据也是一样的道理)。我从四月底开始做外链,陆陆续续做了有 14 条。

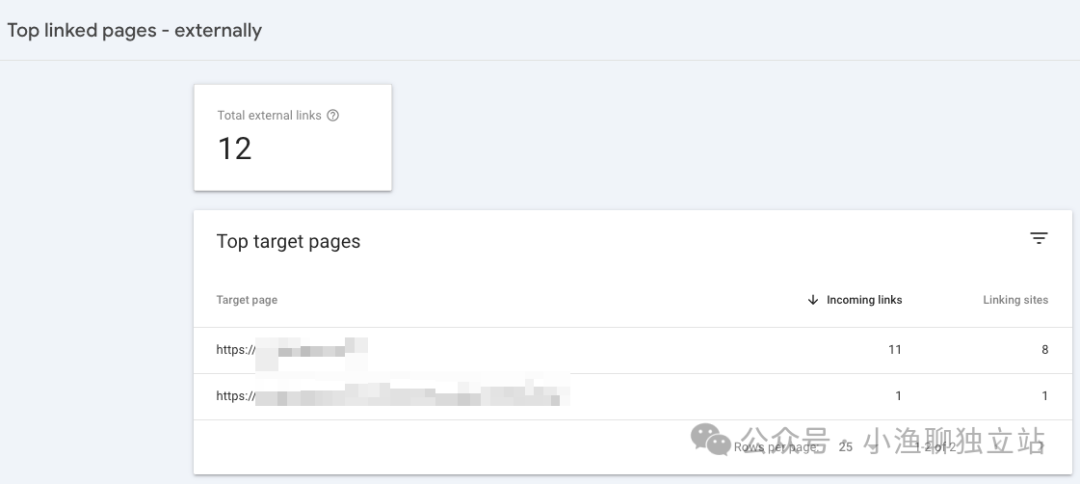

比如上图是谷歌站长工具的数据,上面已经显示了 12 条外链信息(引荐域名),跟我自己的数据基本接近,抓取的信息算是非常准确了。

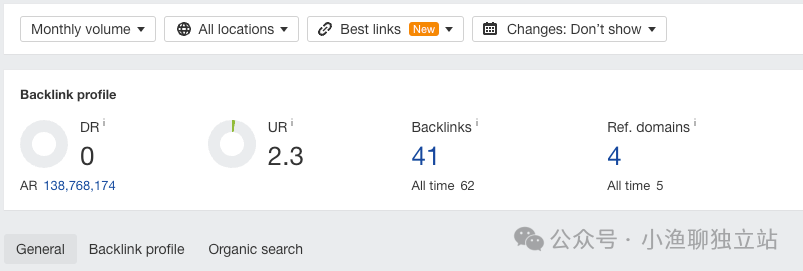

再看 Ahrefs Webmaster Tool 的数据,从结果上看只抓取到了 4 条引荐域名信息。与我自己的实际数据,相差很大。

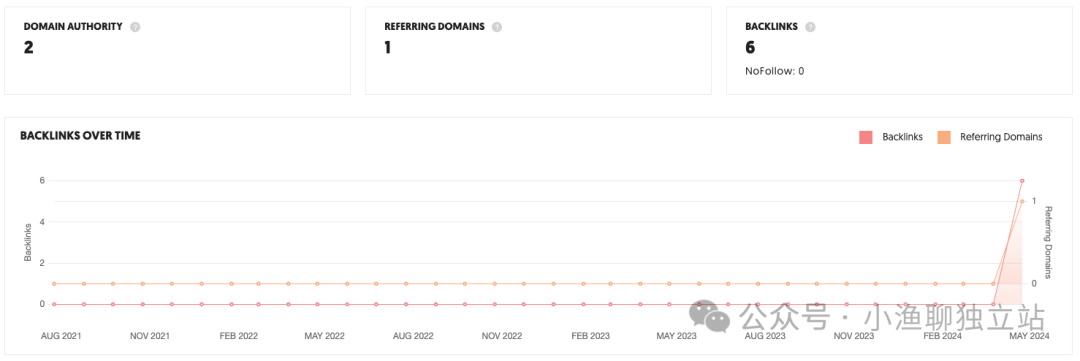

又比如上图是 Ubersuggest 的数据,只显示一条引荐域名信息。

从上面这些信息中可以看到,不同工具对于同一搜索结果,其数据展示还是有很大差异的。至于原因,无非就是不同平台投入的爬虫资源的差异了。

比如谷歌搜索引擎,其爬虫资源肯定是最丰富的。他们的网络爬虫能不间断的搜索全网数据信息,然后整理到自己的数据库中,再在站长工具中展示出来。

而像 Ahrefs,Ubersuggest 这样的第三方数据工具,其配置的网络爬虫资源肯定没有谷歌搜索引擎丰富,那能抓到的数据自然就会少一点,便自然展示出较少结果。

所以对于关键词的搜索量,也是同样的道理。不同平台因为资源配置的差异,肯定会存在数据差异的。且相较于外链数据的抓取,关键词搜索量信息抓取还更复杂一点。

因为全网那么多关键词,且每一天都有新增海量关键词。如果使用爬虫去一一监控,根本就不现实。所以现在普遍通行的方案,就是先对关键词数据进行抽样统计,然后再通过自家的数据模型进行关键词搜索量预测。

搞明白这些,下一步要做的就是这么办了。

我的做法是,一切以谷歌站长工具里面的数据为准。比如关键词出词信息、外链信息,等等这些数据,直接去看谷歌站长工具。可以的话,可以将相应的数据报表下载下来,再去做可视化数据分析。

而对于关键词的搜索量数据,我一般都是参考 Google Keywords Planner 的信息。但是这里存在一个问题,就是当关键词的搜索量数据较小时,在 GKP 里面只显示一个预估值(比如 100-1K)。

所以要想解决这个问题,我建议安装一个 Keywords Everywhere 插件,花一点点钱买个数据包。那下次你在搜索任何词条时,都能在前端给你展示出非常具体的搜索量信息了。

对了,这里有一个点需要注意下。KE 插件在前端直接搜索过程中展示的数据,与 API 方式查询出来的数据,有一定差异。可能是数据源不一样,但是具体原因我还没深究。