顾名思义,对 SEO 成效进行 A/B 测试的目的就是为了验证我们所做的优化操作是否有效,以及能多有效。通过 A/B 测试这个过程,获取到第一手数据反馈,这样才能方便我们下一步在关键词排名、流量获取、或者 On-Page 要素等方面采取下一步行动。

A/B 测试工具

当然,这个测试过程中需要用到一些专业工具,比如 SEOTesting,或者 SearchPilot。除了这些专业工具外,还需要使用到我们耳熟能详的 Google Analytics 与 GSC。

这里先以一个简单案例说下手动进行 A/B 测试的逻辑,以及具体的步骤。

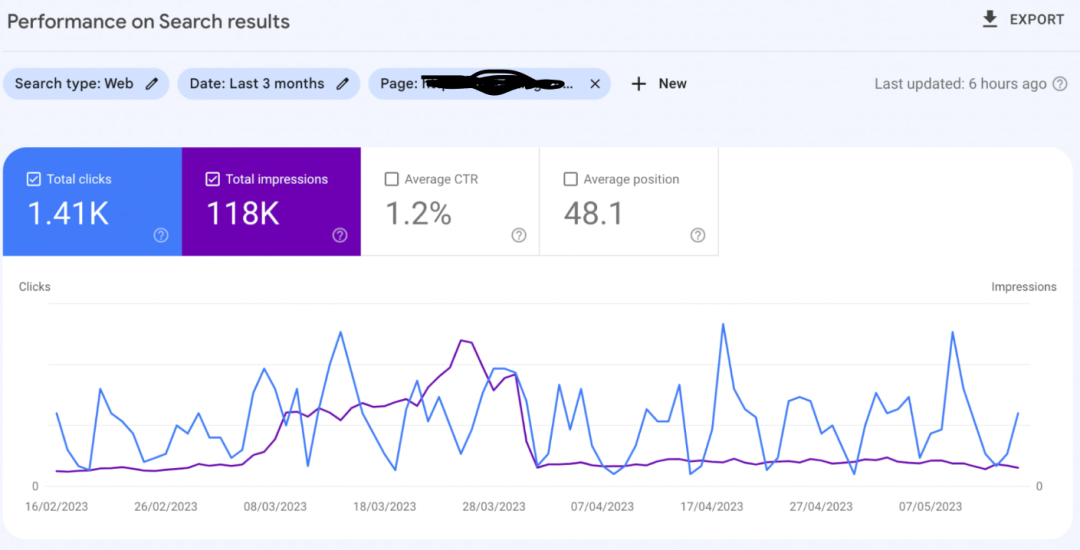

我想更改某个页面的 Meta Desc,来看看是否这部分信息修改会对 SEO 表现产生影响。那第一步就是先通 GSC 导出当时的页面数据,然后再去更改页面的 Meta Desc 信息,重新请求搜索引擎收录后,再去观察一定周期内的数据变化。然后将 Meta Desc 信息修改前后的数据(注意时间周期)作对比,看看曝光、点击、转化各块的数据表现差异,然后再决定下一步操作。

这就是一个很简单的手动进行 SEO 成效测试的步骤,流程上其实不难。重点是需要我们做好数据监控,与测试过程中变量与不变量的把控。

那除了上面提到的手动测试方法外,其实还可以使用专业工具进行 A/B 测试,或分离测试。因为文章篇幅的原因,就大致说说实现逻辑,不贴实际案例了。

这种测试方法的大致逻辑就是,工具会帮助我们生成一个 B 页面,我们可以对 B 页面的相关信息进行修改。然后去观察数据指标(曝光、点击、转化等等),看看我们所做的修改是否有效。这种测试逻辑就跟广告投放的 A/B 测试逻辑一样,只不过呈现方式不一样罢了。

要说明的是,A/B 测试中,A 与 B 这两个页面会去相互竞争资源,是一种竞争关系。而分离测试则不然,工具会根据设定的规则,将流量均匀的分配给 A 与 B 这两个页面。至于具体要选择哪种方式,就得根据业务实际情况而定了。

其实,这种测试方法的应用场景还蛮多的。

比如你对首页单个页面的信息修改,完全可以使用 A/B 测试,来观察两个版本页面在各项指标上的优劣情况。有了第一手数据支撑后,才不至于拍着脑袋做决定。或者你想更换博客的页面显示样式,则可以使用分离测试方法,来找到那个能最大限度调动用户活跃度的版本。

说了这么多,还是想普及下这块内容。因为我发现身边很多 SEOer 虽然已经认识到了优质内容与高相关度外链的重要性,但是在做具体的内容更新决定时,还是唯经验论,而非基于数据表现。如果下次还对内容更新,或者网站样式犹豫不决时,不妨试试这种测试方法,用数据来支撑我们的优化决策。